下一代智能网卡-DPU综述(中) |

作者:小编 发布时间:2022-08-09 |

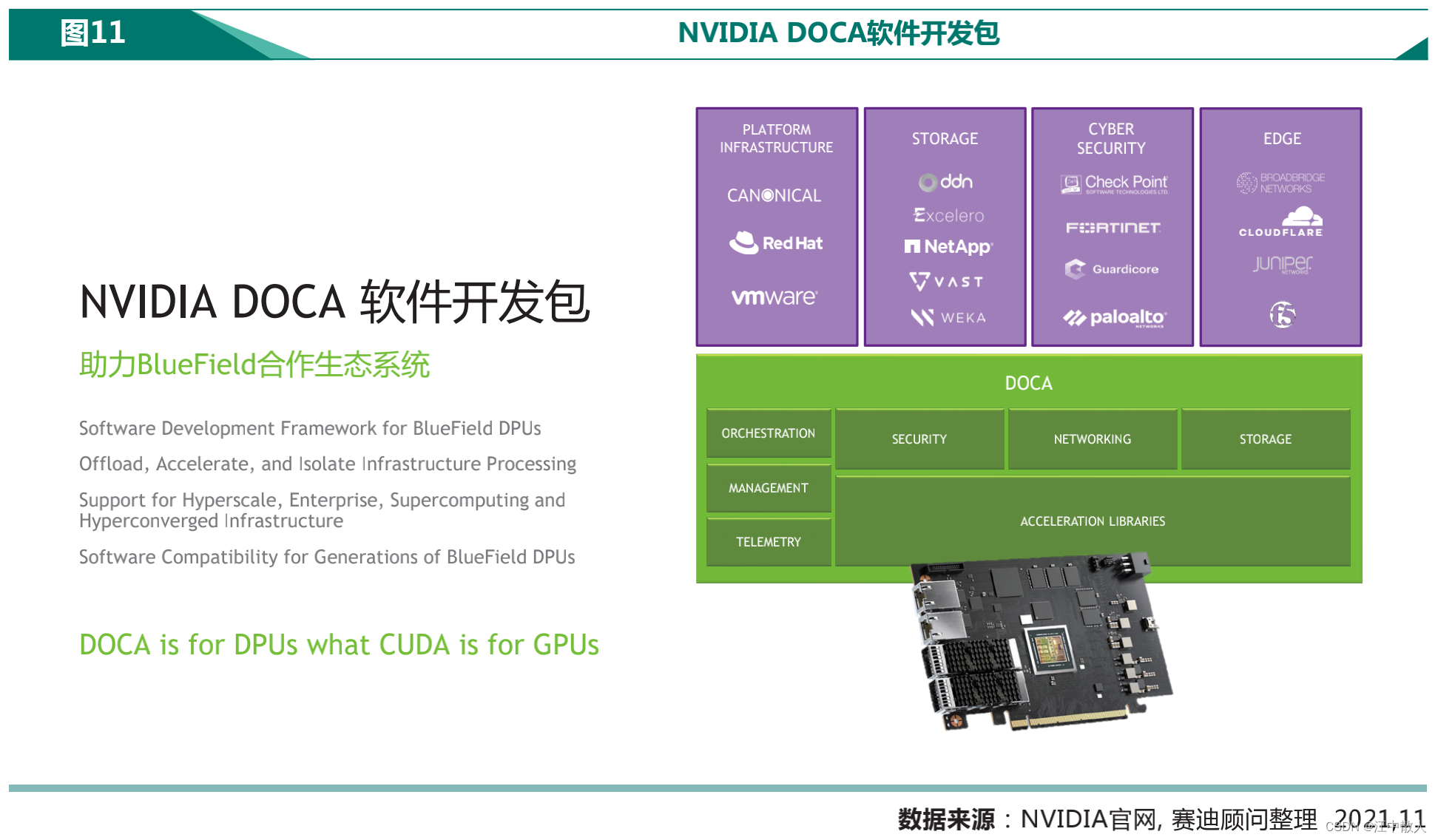

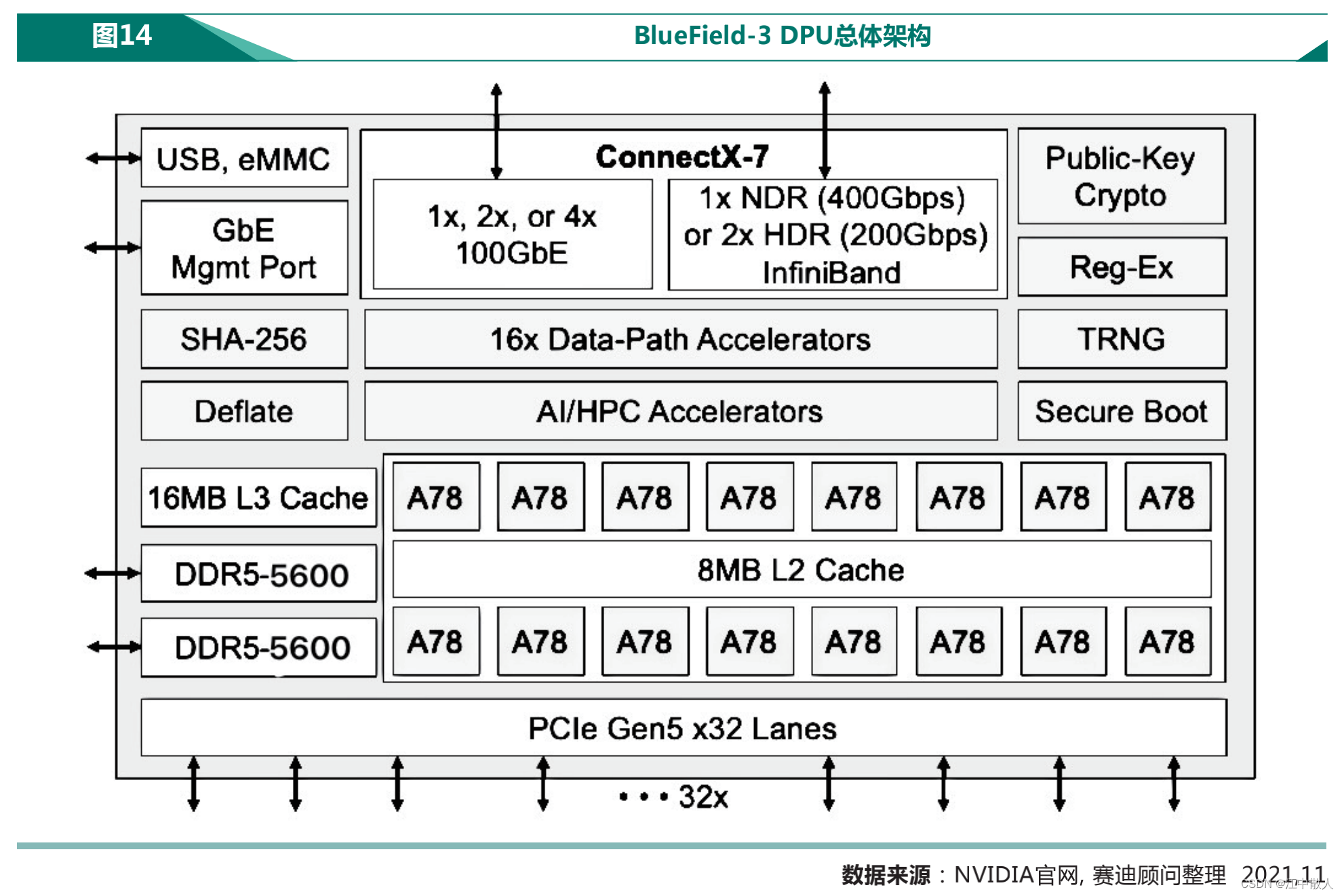

| 1.3.2 BlueField-3 DPU技术特点 BlueField-3 DPU可以从业务应用中将数据中心的基础设施服务卸载和隔离出来,实现了由传统基础设施到现代基于“零信任”环境的转型,可对数据中心的每个用户进行身份认证,保障了企业从云到核心数据中心,再到边缘的安全性,同时在效率和性能上有了更大的提升。 BlueField-3 DPU是首款支持第五代PCIe总线并提供数据中心时间同步加速的DPU。BlueField-3 DPU可为NVIDIA的基于AI技术的网络安全平台,Morpheus提供实时的网络可视化、网络威胁的检测与响应、以及监控、遥测和代理服务。BlueField-3 DPU将传统计算环境转变为安全且加速的虚拟私有云,使组织能够在安全的多租户环境中运行应用程序。BlueField-3 DPU采用NVIDIA的网络计算技术,支持下一代超级计算平台,提供最佳裸机性能和对多节点租户隔离的原生支持。  BlueField-3 DPU利用NVIDIA DOCA™1.1 软件开发包的优势,为开发者提供一个完整、开放的软件平台,开发者在BlueField DPU上开发软件定义和硬件加速的网络、存储、安全和管理等应用。DOCA包含利用BlueField DPU来创建、编译和优化应用的运行时环境,用于配置、升级和监控整个数据中心数千个DPU的编排工具,以及各种库、API和日益增加的各种应用,如深度数据包检测和负载均衡等。每一代BlueField DPU都支持DOCA开发包,随着每代DPU的演进,原先开发的应用程序可以完全向后兼容,且DPU路线图上的后续的产品依然保证完全向前兼容。这意味着在目前BlueField DPU上运行的应用程序和数据中心基础设施,在不久的未来将能不加修改地加速运行在 BlueField-4 DPU等后续产品上。 1.3.3 BlueField-3 DPU产业地位分析 BlueField-3 DPU的出现解决了目前产业无法完全确保数据安全的问题。在零信任的大环境下,产业原本是无法完全确保数据安全的。举例来说,数据中心想支持IPSec协议(即通过加密与验证等方式,为IP数据包提供安全服务),当它在100Gb/s的网络传输数据下,对每一个数据包都进行IPSec加密时,CPU资源会急速耗尽,却依然无法完成在网络高速传输时对每一个数据包都进行IPsec加密的操作。如表4所示,BlueField-3 DPU具备了平台安全、可加密加速、可执行安全策略、深度包检测与隔离安全控制平面的特点,将这个网络层面上确保数据安全的不可能瓶颈打破。

1.3.4 BlueField-3 DPU优势分析1) BlueField-3 DPU拥有更强大的ARM核计算能力和更快的加解密速度,它与CPU、GPU和内存的互连速度也更快。

2) 通过BlueField-3 DPU执行HPC通信框架,可以实现无阻塞通信,即让计算与通信可并行同时发生。目前的超算网络中大多数是有阻塞通信,有阻塞通信是通信与计算不可同时发生,即有通信时不计算,有计算时不通信。目前BlueField-3 DPU在无阻塞集合通信卸载操作上更为成熟,用户可使用配套的MPI库来加速科学计算应用的执行,特别是针对于大规模的的无阻塞all-to-all通信。如图所示,应用BlueField DPU后,计算和无阻塞all-to-all集合通信的之间可100%重叠,如使用DPU加速P3DFFT应用程序(3D快速傅里叶变换)后,应用的总体执行时间减少了25%以上,涵盖了各种大小的网格大小。

3) 在兼容性上,通过使用DOCA库,BlueField-3与上一代DPU上开发的应用保持完全的软件兼容性,软件运行方式没有变化,并得到更高的性能和可扩展性。DOCA在底层硬件API上提供一个抽象层给上层的业务,开发者可以使用标准的API更快速、更轻松地进行开发,实现和上层业务的集成,并经优化后提供出色的性能,或者和底层接口合作达到更精细的控制。且DOCA具备基于容器化服务的DPU调配和部署,包含用于简化DPU设置、配置和服务编排的工具。

1.4 NVIDIA BlueField-3 DPU技术分析和技术对比1.4.1 BlueField-3 DPU技术分析BlueField-3 DPU完全承接了BlueField-2 DPU的先进特性,并将其进行了性能加强与扩展,如下图。

BlueField架构本质上将网卡子系统与可编程数据路径、用于加密、压缩等的硬件加速器子系统以及用于控制的ARM处理器子系统融合在一起。 GPU-direct RDMA技术,简称GDR技术,该技术可实现计算机1的GPU可以直接访问计算机2的GPU内存。而在没有这项技术之前,GPU需要先将数据从GPU内存搬移到系统内存,然后再利用RDMA传输到计算机2,计算机2的GPU还要做一次数据从系统内存到GPU内存的搬移动作。GPU-Direct RDMA技术使得进一步减少了GPU通信的数据复制次数,通信延迟进一步降低。Mellanox网卡已经提供了GPUDirect RDMA的支持(既支持InfiniBand传输,也支持RoCE传输),在英伟达收购Mellanox后,英伟达的所有网卡已全面支持GPU-Direct RDMA技术。

本文内容转载自:csdn网站的云原生专栏,版权归原作者所有,如有侵权请及时联系删除。

|